はじめに:OpenAI Whisperとは?

OpenAI Whisperは、OpenAIによって開発された汎用音声認識モデルだ。多様な言語に対応し、音声を高精度にテキスト化できる。この技術は、議事録の自動作成や動画への字幕付与など、幅広い用途で活用が期待されている。

Whisper のモデルは、オープンソースとして公開されており、個人の PC 環境でも実行できる。https://github.com/openai/whisper参照。

特に、NVIDIA 製の GPU(グラフィックボード)を搭載した PC なら、その高い計算能力を活かして、CPU だけで実行するよりもはるかに高速に文字起こしを行うことが可能だ。この記事では、あなたの Windows 10/11 パソコンで、GPU を使って Whisper を動かすためのセットアップ方法から、基本的な使い方までを解説する。

OpenAI WhisperをWindowsに導入するには、多くのソフトウェアのインストールが必要だ。それを簡単にするためのソフトウェア導入ツールを使う。別記事でも紹介した、Chocolateyだ。これにより、必要なソフトウェアの準備が容易となる。

記事を始める前に

この記事は、以下の環境と条件で進めることを想定している。

- Windows 10 または Windows 11 がインストールされた PC

- NVIDIA 製の GPU を搭載していること(必須ではないが、高速化のため推奨)

- インターネットに接続できる環境

- 管理者権限を持つユーザーアカウントで作業すること

- パッケージ管理システム Chocolateyがインストール済みであること。 Chocolateyのインストール手順参照

これらの準備ができていれば、Whisper を使い始めることができる。

ステップ 1:Python(ver. 3.12)のインストール

Python 3.12と3.13

Whisper は Python というプログラミング言語で書かれているため、まず Python をインストールする必要がある。Chocolateyを用いてPythonをインストールすると、Python本体と、それに付属するパッケージ管理ツールであるpipが一緒に導入される。

pipは、Pythonで書かれた様々な便利なツールやライブラリ(後述するPyTorchやWhisper本体を含む)をインターネットからダウンロードしてインストールするために使用するツールだ。

Whisperは、最新のPythonバージョン(例: Python 3.13)ではビルドや実行に互換性の問題が発生することが確認されている。そのため、ここではWhisperの動作が安定していることが確認されているPython 3.12系をインストールする。 ChocolateyにはPython 3.12系をインストールするためのパッケージが用意されている。

PowerShellを管理者として実行し、以下のコマンドを実行する。choco install python312 -y

このコマンドの -y オプションは、インストール途中の確認プロンプトに全て「はい」と自動で応答する。これにより、非対話的にインストールが進む。

PowerShellの再起動と、場合によっては、PCの再起動

インストール完了時に、Chocolateyから以下のような再起動を推奨するメッセージが表示される場合がある。

The recent package changes indicate a reboot is necessary.このようなメッセージが表示されるのは、Python本体だけでなく、関連する必要なコンポーネント(例: Visual C++ RedistributableなどのC++ランタイム)が同時にインストールされ、それらの変更をシステム全体に確実に反映させるために推奨されているため。メッセージが表示された場合は、指示に従いPCを再起動する。再起動後、改めてPowerShellを開き直して次のステップに進む。

このメッセージが表示されなかった場合は、必ずしも再起動は必要ない。その場合でも、次のステップに進む前に環境変数(パスなど)を読み直すため、PowerShellまたはコマンドプロンプトを一度閉じて新しく開き直した方がよい、かもしれない。

Pythonイントールの確認

インストールが完了したら、新しいPowerShellを開き、以下のコマンドを順に実行してPythonとpipが正しくインストールされ、システムから認識されているか確認。また、Pythonがどこにインストールされたかも確認する。

python --version

pip --version

where.exe pythonpython –version でPythonのバージョン情報、pip –version でpipのバージョン情報が表示されれば、成功。where.exe コマンドは、Python実行ファイルを探す。通常、C:\PythonXX のようなパスが表示されるはず。

パッケージインストールに必要な補助ツールの導入

pip install で他の人の Python パッケージを使う際に、裏側で活躍しているツールとして、setuptoolsとwheelをインストールする。

python -m pip install --upgrade setuptools wheelステップ2: FFmpegのインストール

FFmpegは、音声ファイルや動画ファイルの処理を行うための汎用的なツールだ。Whisperは音声ファイルを読み込む際にFFmpegを利用するため、これも必須となる。

PowerShellを管理者として実行し、以下のコマンドを実行する。

choco install ffmpeg -y-y オプションにより、インストール途中の確認はスキップされ、自動で進む。

FFmpegのインストールでも環境変数が更新される場合があるので、環境変数(パスなど)を読み直すため、新しいPowerShell画面を開き直したほうがよい。

インストールが完了したら、再度PowerShellを開き(環境変数(パスなど)を読み直すため)、以下のコマンドを実行してFFmpegが正しくインストールされたか確認。バージョン情報が表示されれば成功である。

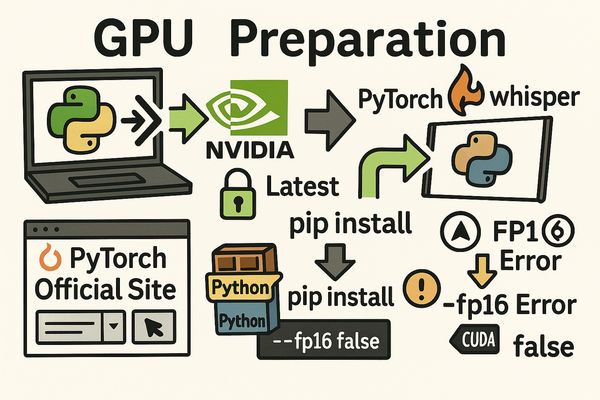

ffmpeg -versionステップ 3:GPU を使うための準備と PyTorch, Whisper のインストール

これまでのステップで、Whisper を動かすための基本的なソフトウェアである Python と FFmpeg が整った。このステップでは、Whisper の「頭脳」として AI 計算を担う PyTorch(パッケージ名は torch)、そして文字起こしプログラムそのものである Whisper ライブラリをインストールする。

特に、PC に NVIDIA 製 GPU(グラフィックボード)がある場合は、Whisper の処理速度を劇的に向上させることができるため、ぜひ使いたい。GPU を使うための準備もこのステップで行う。

GPU を使うための準備:NVIDIA ドライバーの確認・更新 (GPUがある場合)

PC に NVIDIA 製 GPU がある場合、Whisper を GPU で動かすには、NVIDIA の GPU ドライバーを最新の状態に更新しておく必要がある。ドライバーには「Game Ready ドライバー」と「Studio ドライバー」があり、どちらでも動作するが、ゲーム用途でないなら「Studio ドライバー」で問題ない。

以下の NVIDIA 公式ドライバーダウンロードページにアクセスし、あなたの GPU に合った最新版をダウンロード・インストールしてほしい。

NVIDIA公式ドライバダウンロードページ

PyTorchのインストール

次に、PyTorch をインストールする。PyTorch は AI 計算の根幹を担うライブラリであり、GPU を使う場合は GPU 向けのバージョンをインストールする必要がある。PyTorch 公式サイトで、あなたの PC 環境(GPU の有無、OS、Python バージョンなど)に合ったインストールコマンドを取得し、実行するのが最も確実で推奨される手順だ。

以下の PyTorch 公式サイトの「Get Started」ページにアクセスする。

PyTorch公式 https://pytorch.org/get-started/locally/

ページ内のセレクターで、以下の項目を選択する。

- PyTorch Build: Stable (安定版) を選択

- Your OS: Windows を選択

- Package: Pip を選択

- Language: Python を選択

- Compute Platform:

- PCにNVIDIA製GPUがない場合: CPU を選択する。

- PCにNVIDIA製GPUがある場合: 使っているGPUに対応した最新のCUDAバージョンを選択する。

セレクターで全て選び終えると、「Run this Command:」という欄に、あなたの環境に最適な pip install コマンドが表示される。その表示されたコマンドをコピーして使用すること。

例:表示されるコマンドは以下のようになる(環境によって内容は異なる)。

CPU版の例:

pip3 install torch torchvision torchaudioGPU版の例:

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu128PyTorch インストールの実行

PyTorch 公式サイトで表示された pip install コマンドをコピーしたら、通常のユーザー権限のPowerShell画面を開き、そのコマンドを実行する。管理者として実行する必要はない。これにより、あなたの環境に合った PyTorch がインターネットからダウンロードされ、インストールされる。

PyTorch はファイルサイズが大きいため、インストールには時間がかかる場合がある。コマンドの実行が完了し、エラーメッセージが表示されなければ、PyTorch のインストールは成功だ。

【 上記コマンドについての注釈】

- 公式サイトのコマンドは pip3 となっているが、本記事でPython 3をインストールした環境なら pipとpip3は同じである。

- whisper使用には必須ではないtorchvision もインストールされるが、公式サイトの推奨に従う。

GPU版 PyTorch インストールに関する重要な注意点

PC に NVIDIA 製 GPU がある場合、上記の公式サイトの手順で PyTorch の GPU 版(通常は最新の Stable 版と最新の CUDA の組み合わせ)をインストールすると、Small モデルや Medium モデルを GPU で実行する際に、FP16 演算(デフォルト設定)でエラーが発生する場合があることが確認されている。

このエラーが発生した場合、Medium モデルや Small モデルを GPU で安定して使用するには、–fp16 False オプションを付けて FP32 演算で実行する必要がある。この点については、次節以降で、詳しく解説する。まずは公式サイトの手順でインストールを進めてほしい。

Whisperライブラリ本体のインストール (共通)

PyTorch(CPU版またはGPU版)のインストールが完了したら、最後にOpenAI Whisperのライブラリ本体をインストールする。このコマンドは、GPUの有無にかかわらず共通である。

PyTorchをインストールしたのと同じ、管理者として実行していない通常のユーザー権限のPowerShellで、以下のコマンドを実行。

pip install openai-whisperこのコマンドにより、Python Package Index (PyPI) を通じて配布されている openai-whisper の最新安定版がインストールされる。

- 執筆時点での openai-whisper の最新安定版はバージョン 20240930。https://pypi.org/project/openai-whisper/を参照

- このバージョンは、執筆時点で最新の Python 3.13 環境ではインストール時にエラーとなる。ステップ1で Python 3.12 系をインストールすることを推奨したのは、この互換性問題があるため。

これで、Whisperを実行するために必要な主要なライブラリのインストールは完了した。次に、インストールが正しく行われたかを確認し、実際にWhisperを使ってみる。

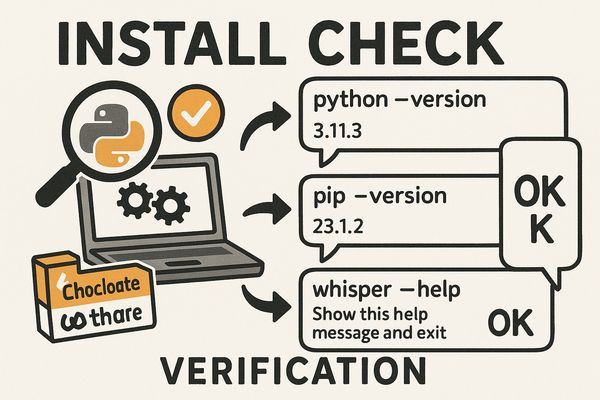

ステップ 4:インストールできたか確認する

これまでのステップで、インストール作業が正しく完了し、Whisper を実行するための環境が整っているか、コマンドを使って確認する。

1. 基本ツールの確認

Python と FFmpeg がシステムから認識されているか確認する。通常のユーザー権限のPowerShellを新規で開き直し、以下を実行。バージョン情報やパスを正しく表示すればOK。

python --version

pip --version

where.exe python

ffmpeg -version2. Python パッケージの確認

pip でインストールした主要パッケージが揃っているか確認する。同じPowerShell画面で以下を実行。

pip list出力されたリストの中に、openai-whisper、torch、torchaudio、torchvision、setuptools、wheel が含まれているか確認。GPU 版 PyTorch の場合は、torch などのバージョンに +cu が付いているはず。

3. PyTorch の GPU 認識確認 (GPU 版のみ)

GPU 版 PyTorch をインストールした場合、GPU が使えるか確認する。同じPowerShell画面で python と入力して対話モードに入る(プロンプトが >>> に変わる)。以下を実行。

import torch

print(torch.cuda.is_available())

print(torch.cuda.get_device_name(0)) 実行結果が True なら GPU を認識している。GPU 名も確認できる。確認後 exit() 、又はCtrl-Zで対話モードを終了。

4. Whisper コマンドの確認

Whisper コマンドが実行できるか確認する。同じPowerShell画面で以下を実行。Whisper のヘルプが表示されればOK。

whisper --help確認の完了

ここまでの確認で全て問題なければ、Whisper を実行する準備は整った。もしエラーがあれば、該当するインストールのステップに戻って再確認が必要だ。

確認が完了したら、次のステップに進み、Whisper を使って実際に文字起こしをする。

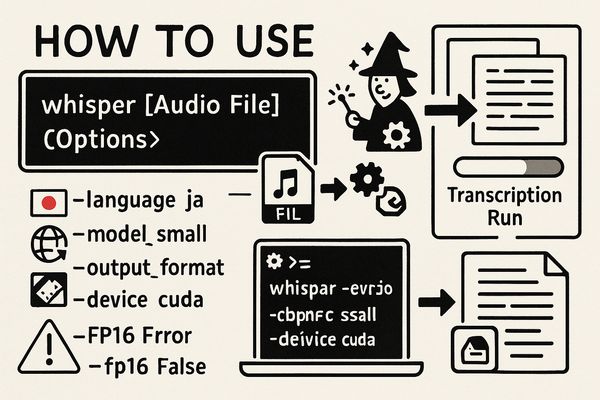

ステップ 5:Whisperを使ってみよう

このステップでは、PowerShell画面から Whisper を実行し、実際に文字起こしを行う。

基本的な使い方は、下記のように、whisper起動時に、音声ファイルと必要なオプションを指定する。

whisper [音声ファイル] [オプション][音声ファイル] には、文字起こしを行いたい音声ファイル名とそのパスを指定する。

オプションには、文字起こしの言語、出力ファイルの形式、使用するデバイス(CPUまたはGPU)、Whisperのモデルサイズ(tinyからlarge、turboまで)、等々がある。

オプションの指定例

よく使うオプションについて説明する。複数のオプションはスペースで区切って並べて指定する。

- 言語の指定 (–language)

音声ファイルが日本語なら –language ja、英語なら –language en のように指定する。言語を指定した方が、文字起こしの精度が向上する場合がある。 - モデルサイズの指定 (–model)

モデルは tiny、base、small、medium、large、そしてturboが利用できる。モデルサイズによって、文字起こしの正確性、処理速度が異なる(モデルの比較は次節で)。モデル指定のない場合、turboモデルがデフォルトで使用される。 例:medium モデルを指定する場合。

whisper audio.wav --model medium- 出力形式の指定(–output_format)

文字起こしの結果、デフォルトでは、コマンドを実行したディレクトリに .txt, .vtt, .srt, .tsv, .json の複数の形式でファイルが生成される。特定の形式だけを出力したい場合は、–output_format オプションを使う。例: テキスト形式 (.txt) だけで出力する場合。

whisper C:\Users\YourName\Desktop\audio.wav --output_format txt— 使用デバイスの指定 (–device)

Whisper を CPU で実行するか、GPU で実行するかを指定する。–device cpu を指定すると CPU で実行される。–device cuda を指定すると GPU で実行される。

※GPU が使える環境(CUDA 版 PyTorch をインストールしている場合)では、–device オプションを付けて GPU を指定した場合も、オプションを省略した場合も、Whisper はデフォルトで GPU を使おうとする。

【重要】GPU を使って文字起こしを行う場合の注意点:FP16 演算エラーとその対処法

GPU が使える環境で、特に Small モデルや Medium モデル を使って文字起こしを行う際に、NaN (Not a Number) エラーが発生する場合がある。

特定の NVIDIA GPUと PyTorch のバージョン(現在の Stable 版 2.7.0 以降など)の組み合わせで、Small モデルや Medium モデルを GPU 上で FP16 演算(これが Whisper のデフォルトの演算精度) で実行する際に、このエラーが発生し、文字起こしが失敗することがある。Base モデルや Tiny モデルでは、このエラーは発生しにくい。

もし、smallモデルや、それより大きいモデル(Medium, Large, Turbo など)で GPU を使って文字起こしを実行しようとして(–device cuda を付けた場合も、付けなかった場合も)、以下のような NaN エラーを含むメッセージが表示された場合は、この問題に遭遇している。

ValueError: Expected parameter logits (...) but found invalid values:

tensor([[nan, nan, nan, ..., nan, nan, nan],

...], device='cuda:0')GPU 使用時のエラー回避策:–fp16 False オプション

上記の NaN エラーが発生する場合、Smallモデルや、それより大きいモデルを GPU で安定して使用するには、–fp16 False オプションをコマンドに付けて、FP32 演算で実行する必要がある。このオプションを付けることで、FP16 演算による問題を回避し、GPU を使って文字起こしを完了させることができる。

GPU で Small モデルを使う場合のコマンド例 (エラー回避策適用):

whisper [音声ファイル] --model small --language ja --device cuda --fp16 False上記は Small モデルの例だが、Medium モデル、Large モデル、Turbo モデル を GPU で使う場合も、同様にコマンドに –fp16 False オプションを付けて実行する。

文字起こし実行例

実際に文字起こしを実行してみよう。例えば jpn-test.mp3、という音声ファイルが、デスクトップに保存されていると仮定する。これを、small モデルで日本語として文字起こしし、結果をテキストファイルとして出力する場合を考える。GPUを使っているので、エラー回避のオプションもつけている。

通常のユーザー権限のPowerShell(またはコマンドプロンプト)を開く。PowerShell画面で、音声ファイルが保存されているディレクトリに移動するか、音声ファイルのフルパスを指定する。

デスクトップに jpn-test.mp3 があるとして、以下のコマンドを実行する。

whisper C:\Users\YourName\Desktop\jpn-test.mp3 --model small --language ja --device cuda --fp16 False --output_format txtコマンドを実行すると、Whisper が起動し、モデルのダウンロード(初めてそのモデルを使う場合)や音声の処理、文字起こしが進行する様子がPowerShell画面に表示される。処理には、音声ファイルの長さや使用するモデル、PC の性能(特に GPU の有無)によって時間がかかる場合がある。

実行結果の確認

コマンドの実行が完了すると、指定した出力形式(例: txt)のファイルが、通常はコマンドを実行したディレクトリ、あるいは音声ファイルが保存されているディレクトリに生成される。

上記の例であれば、コマンドを実行したディレクトリに jpn-test.txt というテキストファイルが生成されているはずだ。このファイルを開くと、文字起こしされたテキストが表示される。

もし –output_format を指定しなかった場合は、txt 以外にvtt、srtなど複数のテキストファイルが生成される。

これで、Whisper を使って音声ファイルの文字起こしを実行する基本的な手順は完了だ。

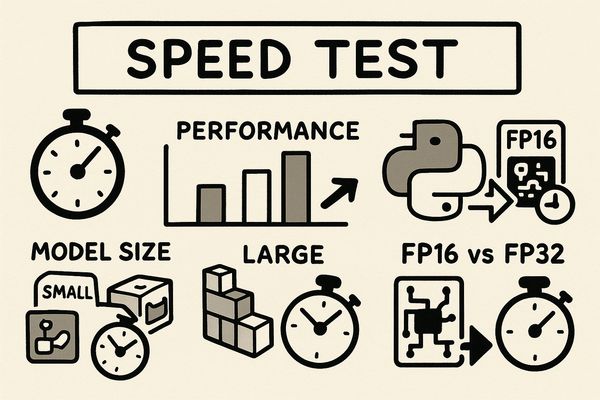

Whisperのモデルごとの演算速度の比較、CPUとCUDAの速度比較

Whisper の文字起こし速度は、モデルサイズや使用デバイス(CPU または GPU)によって大きく変動する。ここでは、私の PC 環境で実際に行った速度測定の結果を例に示す。

測定環境と条件

- 対象ファイル: 約 3分(180秒)の音声ファイル

- デバイス: CPU および GPU (CUDA)

- GPU 環境: NVIDIA GeForce GTX 1660 Ti、PyTorch Stable 版 2.7.0+cu128 など

- 演算精度: GPU 実行時は FP16 または FP32 (–fp16 False) を使用。CPU 実行時は FP32 演算となる

測定結果

約 3分の音声ファイルに対する各条件での処理時間(TotalSeconds)は以下の通りだ。

| モデルサイズ | デバイス(演算精度) | 処理時間 |

|---|---|---|

| tiny | CPU (FP32) | 23.44 秒 |

| base | CPU (FP32) | 46.39 秒 |

| tiny | CUDA (FP16) | 17.27 秒 |

| tiny | CUDA (FP32) | 15.60 秒 |

| base | CUDA (FP16) | 21.75 秒 |

| base | CUDA (FP32) | 17.34 秒 |

| small | CUDA (FP32) | 27.13 秒 |

| medium | CUDA (FP32) | 49.35 秒 |

| turbo | CUDA (FP32) | 38.84 秒 |

※結果は環境により異なるので、絶対的な数値は気にせず、相対的な比較だけ見て欲しい。

考察

- GPU は CPU より圧倒的に高速: Base モデルや Tiny モデルを比較すると、CPU より GPU(CUDA) の方が大幅に高速だ。

- モデルサイズと速度: モデルサイズが大きいほど処理時間が長くなる傾向がある (tiny < base < small < medium)。

- FP16 vs FP32 の速度差: 私の環境での測定では、FP32 演算の方が FP16 演算よりも少し速い。本来、FP16 のほうが、より高速になるはずだが、私の環境ではうまく設定されていない気がする。

- turboモデル: 約 38.84 秒で、Medium より速いが Base や Small より遅い。このモデルは openai-whisper 20240930 で導入された新しい標準モデルで、Whisper実行時、モデル指定を省略すると自動的に使われる。従来の large や medium に比べて、推論速度と音声認識精度のバランスを最適化したとされている。

まとめ

この記事は、Windows 10/11 パソコンで、NVIDIA 製 GPU を使って OpenAI Whisper でサクッと音声文字起こしを高速化する方法について、私がAIに助けてもらいながらまとめたものだ。

具体的には、記事のステップを一つずつ進めることで、Whisper を動かすために必要な基本的なソフトウェア(Python, FFmpeg, PyTorch, openai-whisper)のインストールから、Whisper の基本的な使い方、そして GPU を使うとどのくらい速くなるか、といったパフォーマンスのことまで、確認してきた。

特に、GPU を使うと CPU だけでやるよりも段違いに速く文字起こしができることや、使うモデルのサイズで速さや精度が変わること、「あれ?なんかエラーが出たぞ?」と思った時に、FP16 演算が原因かもしれないこと、そしてそんな時にどうすればいいか、みたいなことも確認している。

今回解説した内容は、Windows で Whisper を使い始めるための基本的な部分だ。Whisper には、他にも色々な便利な機能やオプションがある。もし興味があれば、色々な設定を試してみて、さらにあなたの用途に合った使い方を探求することもできるはずだ。